-

[SWAG] A simple Baseline for Bayesian Uncertainty in Deep LearningBayesian 2025. 7. 1. 23:14

https://campusai.github.io/papers/maddox_et_al_bayesian_uncertainty_deep_learning

CampusAI

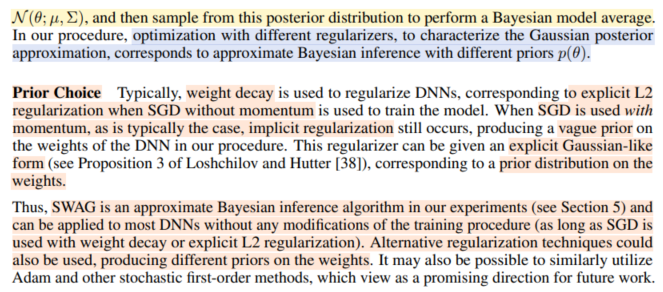

This paper proposes the SWA-Gaussian algorithm for uncertainty representation and calibration in Deep Learning. Standard Neural Networks do not provide any information about the confidence of their predictions. The SWAG algorithm proposed in this paper ach

campusai.github.io

https://www.youtube.com/watch?v=qc4s_VH5JOY

↑ ↑ ↑ ↑ ★강추 ↑ ↑ ↑ ↑ (+ SWA 동영상도 있다)

SWA / SWAG 를 잘 설명해주실 뿐만 아니라,

Bayesian deep learning의 핵심 idea와 주요 methodology를 잘 톺아주신다.

MCDropout, Laplace approximation, SWA, SWAG, SGMCMC (sampling) 등을 전반적으로 살펴보고 나니, posterior를 approximate 하기 위해서 참 다양하고 기발한 아이디어가 많았구나 싶다.

의외로 idea는 simple하다.

bayesian deep learning을 실현한 다른 방법론들과 달리, 내가 본 논문을 자세히 본 이유는,

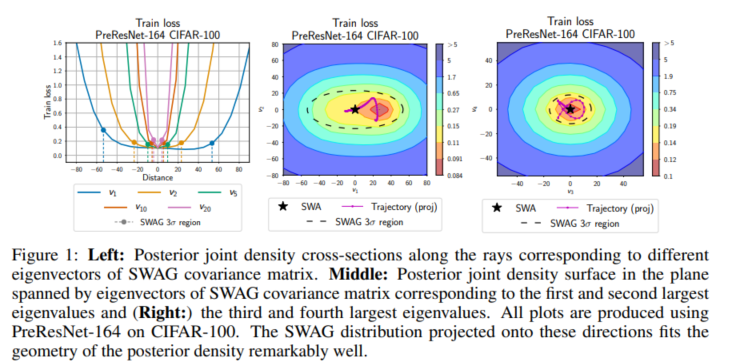

어떻게 efficient하게 만들었는지 (row rank approximation)

그리고 SGD Trajectory가 실제로 loss geometry를 포착하는가를 어떻게 validate했는지 (SVD)를 살펴보고 싶었다.

논문 재미있게 읽었다.

'Bayesian' 카테고리의 다른 글

[A][Deep Ensembles] A Loss Landscape Perspective (0) 2025.07.03 [Q][Deep Ensembles] Simple and Scalable Predictive Uncertainty Estimation using Deep Ensembles (0) 2025.07.03 Deep Networks are Kernel Machines (0) 2025.07.01 Deep Neural Networks as Gaussian Processes (0) 2025.06.30 Kernel Methods (0) 2025.06.30